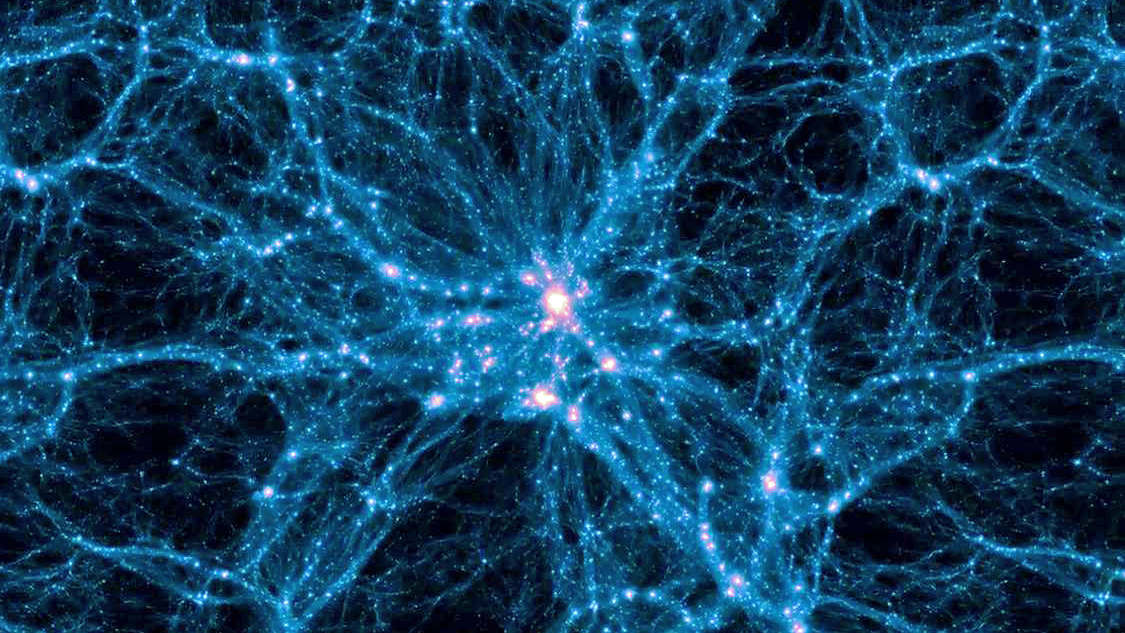

Grupa astronomów z wielu krajów przeprowadziła największą w historii symulację kosmologiczną, w której uwzględniona została zarówno ciemna, jak i znana nam materia, z której składają się planety, gwiazdy i galaktyki. Wyniki symulacji dały nam nowe spojrzenie na ewolucję naszego wszechświata.

Symulacje FLAMINGO stworzono do obliczania ewolucji wszystkich składników wszechświata, zarówno tych, które znamy bardzo dobrze, jak i tych, o których istnieniu wiemy, a których nigdy jeszcze nie zdołaliśmy w żaden sposób dotknąć. Mowa tutaj oczywiście odpowiednio o materii zwyczajnej, ciemnej materii i ciemnej energii. Raz uruchomiona symulacja tego typu śledzi uważnie powstawanie wirtualnych galaktyk, a następnie gromad galaktyk. Zespół badawczy odpowiedzialny za to przełomowe osiągnięcie opublikował właśnie w periodyku naukowym Monthly Notices of the Royal Astronomical Society trzy artykuły opisujący szczegółowo metody badawcze, samą symulację oraz porównanie jej z obserwowaną wielkoskalową strukturą wszechświata.

Można zapytać, po co komu wiedza o wirtualnych galaktykach. Okazuje się jednak, że symulacje są niezwykle przydatne w dobie gigantycznych teleskopów kosmicznych, takich jak Kosmiczny Teleskop Jamesa Webba czy wystrzelony dopiero europejski teleskop Euclid. Zbierają one olbrzymie ilości danych o galaktykach, kwazarach i gwiazdach. Symulacje pozwalają nam zinterpretować te dane poprzez łączenie naszej teoretycznej wiedzy o wszechświecie z obserwowanymi we wszechświecie obiektami.

Obserwuj nas na WhatsAppie! Nie ominie cię żaden artykuł.

Według naukowych wszystkie właściwości wszechświata opierają się na zaledwie kilku liczbach, tzw. parametrach kosmologicznych. Wartości tych parametrów są od dekad mierzone coraz bardziej precyzyjnymi metodami.

Jedna z tych metod opiera się na badaniu właściwości kosmicznego mikrofalowego promieniowania tła (CMB), słabej poświaty będącej pozostałością po wczesnym Wszechświecie. Problem w tym, że wartości zmierzone tą metodą nie odpowiadają wartościom mierzonym innymi technikami opierającymi się na tym jak siła grawitacyjna galaktyk zagina światło (soczewkowanie). Takie właśnie różnice mogą według wielu badaczy wskazywać na klęskę standardowego modelu kosmologii – modelu zimnej ciemnej materii.

Symulacje komputerowe mogą wskazać przyczynę tych rozbieżności, wskazując naukowcom odchylenia w pomiarach. Jeśli jednak żadne z nich nie okaże się wystarczające do wyjaśnienia rozbieżności, dotychczas obowiązująca teoria będzie miała poważne kłopoty.

Jak dotąd symulacje komputerowe wykorzystywane do porównań z obserwacjami skupiają się jedynie na zimnej ciemnej materii. Warto tutaj pamiętać jednak, że choć ciemna materia dominuje grawitacyjnie we wszechświecie, nie można w pomiarach ignorować wkładu zwykłej materii. Jakby nie patrzeć to właśnie ten wkład może odpowiadać za różnice między modelami a obserwacjami.

Pierwsze wyniki pokazują, że zarówno neutrina, jak i zwykła materia są niezbędne do dokonywania dokładnych przewidywań, ale wciąż nie eliminują różnic pomiędzy różnymi obserwacjami kosmologicznymi.

Symulacje, które śledzą również zwykłą materię barionową, są znacznie trudniejsze do wykonania i wymagają znacznie większej mocy obliczeniowej. Dzieje się tak dlatego, że zwykła materia – która stanowi zaledwie szesnaście procent całej materii we wszechświecie – odczuwa nie tylko grawitację, ale także ciśnienie gazu, które może powodować wywiewanie materii z galaktyk daleko w przestrzeń międzygalaktyczną np. przez aktywne czarne dziury i supernowe.

Siła tych międzygalaktycznych wiatrów zależy od eksplozji w ośrodku międzygwiazdowym i jest bardzo trudna do przewidzenia. Oprócz tego istotny jest udział neutrin, czyli cząstek subatomowych o bardzo małej, ale nie dokładnie znanej masie, których jednak jak dotąd nie symulowano.

Astronomowie przeprowadzili serię symulacji komputerowych śledzących powstawanie struktur w ciemnej materii, zwykłej materii i neutrinach. W toku swoich prac bezustannie zmieniali parametry modelu, w tym siłę wiatrów galaktycznych, masę neutrin oraz parametry kosmologiczne w symulacjach nieco mniejszych, ale wciąż uwzględniających duże objętości.

W największej symulacji wykorzystano 300 miliardów elementów tj. cząstek o masie małej galaktyki w objętości sześcianu o krawędziach sięgających dziesięciu miliardów lat świetlnych. Uważa się, że jest to największa kosmologiczna symulacja komputerowa uwzględniająca zwykłą materię, jaką kiedykolwiek ukończono. Aby udało się ją przeprowadzić, niezbędne było opracowanie nowego kodu, który efektywnie rozdziela pracę obliczeniową na 30 tysięcy procesorów.

Można zatem śmiało powiedzieć, że symulacje FLAMINGO otwierają nowe wirtualne okno na wszechświat, które pomoże w maksymalnym wykorzystaniu obserwacji kosmologicznych. Ponadto duża ilość (wirtualnych) danych stwarza możliwości dokonywania nowych odkryć teoretycznych i testowania nowych technik analizy danych, w tym uczenia maszynowego.

Korzystając z uczenia maszynowego, astronomowie mogą następnie prognozować losowe wirtualne wszechświaty. Porównując je z obserwacjami struktur na dużą skalę, można zmierzyć wartości parametrów kosmologicznych. Co więcej, mogą mierzyć odpowiednie niepewności, porównując je z obserwacjami ograniczającymi wpływ wiatrów galaktycznych.